Einsatz von künstlicher Intelligenz im Bereich E-Mental-Health

Autorinnen:

Univ.-Prof. Dr. phil. habil. Christiane Eichenberg

Raphaela Schneider, MSc

Institut für Psychosomatik der Fakultät für Medizin

Sigmund Freud PrivatUniversität Wien

E-Mail: c.eichenberg@sfu.ac.at

Sie sind bereits registriert?

Loggen Sie sich mit Ihrem Universimed-Benutzerkonto ein:

Sie sind noch nicht registriert?

Registrieren Sie sich jetzt kostenlos auf universimed.com und erhalten Sie Zugang zu allen Artikeln, bewerten Sie Inhalte und speichern Sie interessante Beiträge in Ihrem persönlichen Bereich

zum späteren Lesen. Ihre Registrierung ist für alle Unversimed-Portale gültig. (inkl. allgemeineplus.at & med-Diplom.at)

Künstliche Intelligenz wird bei E-Mental-Health-Maßnahmen aktuell nur vereinzelt genutzt – ihr Potenzial ist allerdings groß und vielversprechend. Nicht nur für Fachpersonal, sondern vor allem für Betroffene von psychischen Krankheiten kann sie in Zukunft eine hilfreiche Unterstützung darstellen. Die Qualität der Interaktion zwischen Mensch und künstlicher Intelligenz wird für den Erfolg ausschlaggebend sein.

Ein aktueller Ansatz im Bereich des gesunden Alterns ist die Entwicklung adaptiver Roboterplattformen, die individuelle Verhaltensänderungen und emotionale Zustände älterer Menschen erkennen und darauf reagieren. Mehrere Studien über das persönliche Roboterunterstützungssystem ROSS (Abb. 1) zeigten, dass solche Technologien eine Schlüsselrolle in der Förderung der Lebensqualität älterer Menschen spielen können.1–3 Die Studienergebnisse unterstreichen die positive Wahrnehmung und Effektivität dieser Interventionen, insbesondere bei Aufgaben, die das Wohlbefinden fördern. Die Teilnehmer bewerteten die Interaktionen mit ROSS überwiegend positiv, äußerten allerdings den Wunsch nach höherer Kommunikationsfähigkeit und stärkerer Personalisierung. Diese Ergebnisse deuten darauf hin, dass die richtige Balance zwischen Motivation, Timing und Aufgabenbeliebtheit für den Erfolg dieser Systeme entscheidend ist. Emotionsbasierte Interventionen, die auf Valenz- und Aufmerksamkeitsmessungen basieren, können dabei helfen, den richtigen Zeitpunkt für eine Intervention zu bestimmen. Insgesamt bieten adaptive Roboterplattformen wie ROSS großes Potenzial für die Unterstützung älterer Menschen, sowohl im physischen als auch im psychischen Bereich.

Abb. 1: Interaktion mit ROSS (Quelle: https://www.aid2bewell.eu )

Das Potenzial von KI

Im Gegensatz zur Anwendung von künstlicher Intelligenz (KI) im medizinischen Bereich gibt es vergleichsweise nur eine geringe Verbreitung im Feld von E-Mental-Health.4 Hier sind vor allem Pilotprojekte wie ROSS vorherrschend.

Diagnostik

Grundsätzlich können KI-Anwendungen mit dem momentanen Entwicklungsstand, der eine Verarbeitung großer Trainingsdaten möglich macht, in der Diagnostik, Prognose und Behandlungsplanung hilfreich sein.4 Das Potenzial liegt insbesondere in organisatorischen oder dokumentarischen Aufgaben. Diese kosten wertvolle Behandlungszeit, die dadurch den Patienten zur Verfügung gestellt werden kann.4 Einschränkend dabei ist das Fehlen von sehr großen und strukturierten Datenmengen im psychiatrischen Bereich,4 die die KI als Trainingsmaterial auf Basis von Maschinenlernen benötigt. Anwendungsbeispiele im psychiatrischen Bereich finden sich unter anderem in der Diagnostik von Depression,5 PTBS6,7 und Schizophrenie.8

Chatbots zur Intervention

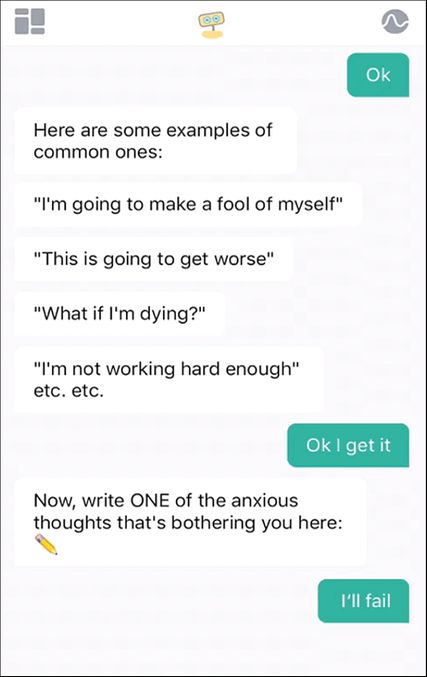

Auch Chatbots werden im E-Mental-Health-Bereich eingesetzt, wenn aktuell auch eher selten.9 Ein Chatbot ist eine digitale Anwendung basierend auf künstlicher Intelligenz, die eine Interaktion mit einer anderen Person simuliert.10 In einem Scoping-Review fanden Abd-Alrazaq et al.9 41 verschiedene Chatbots, die eigenständig mit Menschen interagieren und im E-Mental-Health-Bereich eingesetzt werden. Die meisten davon sind regelbasiert programmiert, d.h., sie verwenden ein Skript, das auf bestimmte Schlagworte immer die gleiche Reaktion, nach Regeln abgeleitet, ausgibt.9 Grund dafür ist die Kontrolle über die Qualität der Interaktion mit vulnerablen Personen, da ein regelbasierter Chatbot nicht von den Regeln abweichen kann, eine KI basierend auf „deep learning“ oder „Large language“-Modellen allerdings selbstlernend ist und anhand von Datenmaterial trainiert, selbstständig Output verfasst, wobei die Qualität dieses Outputs nicht gleichbleibend hoch ist. Beispiele für einfache regelbasierte Chatbots sind die App „Woebot“ (Abb.2), die sich in einer kurzen zweiwöchigen Intervention bei nach Selbsteinschätzung depressiven und ängstlichen Studenten als wirksam zeigte,11 oder „Shim“, eine automatisierte Chat-Anwendung im nicht-klinischen Bereich, deren Nutzende nach kurzer Nutzungsdauer weniger Stress und größeres Wohlbefinden berichteten.12 Diese Anwendungen sind auf wenige, kurze Antworten und Bemerkungen beschränkt.

Morris et al.13 stellten einen empathischen Chatbot für Hilfesuchende vor, der Zugriff auf Antworten von Peer-Beratern auf einer Plattform zur niederschwelligen Single-Session-Beratung durch Peers hatte. Im Experiment konnten Hilfesuchende auf derselben Plattform auswählen, ob sie während der Wartezeit auf eine Peer-Antwort eine Hilfestellung des Chatbots lesen wollen. Letzterer verwendete Software, die ähnliche Posts von Hilfesuchenden aus der Datenbank mit früheren Peer-Antworten herausfilterte und den Hilfesuchenden erneut anbot. Sprich, die Antworten wurden nicht selbst generiert, sondern in einem Vergleichsprozess nach Ähnlichkeit angeboten. Die Hilfesuchenden werteten diese Antworten zu knapp 80% als angemessen.

ChatGPT

Die rasante Entwicklung im Bereich der natürlichen Sprachverarbeitung und des „deep learning“ führte in den letzten Jahren dazu, dass neue Modelle wie GPT („generative pre-trained transformer“) von OpenAI14 Sprache selbst erzeugen können und damit die Einsatzmöglichkeiten auch im E-Mental-Health-Bereich enorm erweitern können. Im November 2022 wurde der Chatbot ChatGPT von OpenAI der breiten Öffentlichkeit zu Forschungs- und Entwicklungszwecken bereitgestellt.14 Über ein Chatfenster kann ChatGPT mit angemeldeten Nutzenden kostenlos interagieren, Fragen beantworten, Texte schreiben, Lieder oder Gedichte erfinden und programmieren.15 ChatGPT baut Wissen zu einer geführten Interaktion auf, kann dadurch valide Rückfragen stellen, auf die Interaktion mit einer bestimmten Person zu verschiedenen Zeitpunkten zurückgreifen und theoretisch ohne zeitliche Grenzen kommunizieren. Im Jänner 2023 gaben schon 27,7% der deutschen Internetnutzer an, den Chatbot zu kennen, 11% haben ihn schon gelegentlich verwendet und 55% der Befragten sind dem Chatbot gegenüber positiv eingestellt.15 ChatGPT überrascht sogar KI-Forscher mit seinen Fähigkeiten, die durch Rückmeldungen zur Qualität der Antworten von Menschen trainiert wurden.16

„Prompt engineering“

Für die Qualität der Antworten spielt das Prompten eine große Rolle, das man als eine Aktivierung bestimmter Wissensbestände durch den in der Eingangsfrage eingegebenen Kontext verstehen kann.17 Die Disziplin des „prompt engineering“ beschäftigt sich damit, in welchem Kontext (einleitende Informationen und Beispiele) das Sprachmodell so aktiviert wird, dass der Output bestmöglich ist.17 OpenAI stellt Richtlinien zur Erstellung von Prompts zur Verfügung und weist darauf hin, dass ChatGPT ohne Prompt oder mit dem falschen Prompt den Interaktionspartner nachahmen, abschweifen oder sarkastisch antworten kann.14 Weiter werden folgende Punkte von OpenAI als einschränkend genannt: ChatGPT kann falsche, aber plausibel klingende Antworten verfassen, es reagiert sensibel auf Änderungen bei Eingaben oder auch mehrfach wiederholter Eingabe (kann einmal keine Antwort kennen, dann wieder richtig antworten), es kommuniziert eher mit übermäßig vielen Worten und wiederholt bestimmte Phrasen häufig, es fragt bei uneindeutigen Eingaben nicht nach, sondern errät die Intention, außerdem kann es trotz Training unangemessene Antworten geben.14

Aktuelle Forschung mit „Large language“-Modellen (LLM) zeigt das Potenzial dieser Technik im E-Mental-Health-Bereich. Kumar et al.17 testeten drei verschiedene Prompt-Dimensionen (Identität, Intention und Verhalten) eines LLM in einem faktoriellen Zufallsexperiment, bei dem Probanden in einem stressfördernden Arbeitsumfeld zur Verbesserung des Wohlbefindens fünf Minuten lang mit dem Chatbot interagieren konnten. Die Probanden der Studie bewerteten den Chatbot insgesamt als hilfreich und im Speziellen als unvoreingenommen, nachdenklich und leicht zu verstehen. Als negativ wurden Bedenken in Bezug auf den Datenschutz oder repetitives Verhalten der KI genannt. Im Allgemeinen gaben Probanden ein mäßig hohes Risiko bei der Interaktion mit dem Chatbot, mäßiges Vertrauen, große Kompetenz des Chatbots und mäßige Bereitschaft, erneut mit dem Chatbot zu interagieren, an.

Weiterentwicklung der GPT-Modelle

Im März 2023 wurde die Bezahlversion „ChatGPT Plus“ veröffentlicht, die multimodal ist und erstmalig auch Bildmaterial verarbeiten kann.14 Die Überlegenheit von ChatGPT Plus gegenüber der Vorversion zeigt sich in komplexen Aufgaben; es ist zuverlässiger, kreativer und versteht komplexe Anweisungen besser (ebd.). Fachleute schreiben dem neuen Modell GPT4 zu, Anzeichen einer generellen künstlichen Intelligenz zu zeigen.18 Die Autoren berichten, dass GPT4 auf fast menschenartigem Niveau komplexe medizinische und psychologische Anfragen, sogar ohne Prompts, beantworten kann. Nori et al.19 konnten nicht nur zeigen, dass das neue Modell GPT4 die amerikanischen medizinischen Abschlussprüfungen besser als das alte Modell GPT3 besteht, sondern haben das Modell theoretisch in Aufgaben aus der Ausbildung von Medizinern getestet. Sie legten der KI einen Fall zur Einordnung dar, gaben die Einschätzung eines Medizinstudenten als Input, ließen die KI erklären, wie der Studierende zu dieser Einschätzung kam, und sie zuletzt eine schriftliche pädagogische Rückmeldung für den Studierenden geben. Die Autoren schließen auf ein großes Potenzial bei der Ausbildung von Medizinern und als Unterstützung für das medizinische Fachpersonal. Vom Einsatz bei der direkten Behandlung raten sie wegen der oben genannten Fehler und Ungenauigkeiten ab. Auch die Stellungnahme des deutschen Ethikrats zum Einsatz künstlicher Intelligenz geht mit dieser Einschätzung konform: KI sollte den Menschen nicht ersetzen, da sie kein verantwortungsvolles Agens ist.20

Ausblick

KI wird in Zukunft auch im Bereich E-Mental-Health einen wachsenden Einfluss haben. Dieser betrifft zum einen das Potenzial für die Ausbildung von Beratern und Therapeuten, zum anderen die Anwendung in klinischen wie nichtklinischen Bereichen. Für den Ausbildungsbereich können Ergebnisse einer Studie21 anregend sein, die zeigte, dass die Unterstützung eines Chatbots basierend auf „deep learning“ nicht ausgebildeten Beratenden als eine Art Echtzeit-Supervision zur Seite gestellt werden kann, um die Beratungsqualität zu verbessern. Für die Anwendung bei Betroffenen psychischer Probleme spielt die Akzeptanz von KI eine Schlüsselrolle. Eine Umfrage zum Vertrauen in KI-Anwendungen im Bereich der psychischen Gesundheit zeigte, dass Probanden zwar aktuell solche Anwendungen wenig verwenden, aber 67,2% der Befragten in den nächsten zehn Jahren eher dazu bereit sind.22 Somit sollten psychosoziale Fachkräfte davon ausgehen, dass Betroffene diese Tools auch im Bereich psychischer Gesundheit nutzen, sodass zentral ist, dass sie über neueste Trends informiert sind und ebenso aktiv den Dialog über die Erfahrungen, Chancen und Risiken mit ihren Klienten suchen. Auch über unterstützende Möglichkeiten zur Schließung von Versorgungslücken, z.B. im Bereich der Kinder- und Jugendlichenpsychotherapie, v.a. in unterversorgten Ländern, wird diskutiert.23

Aber auch aktuelle Forschungsergebnisse aus der kognitiven Psychologie unterstreichen die Notwendigkeit, dass Behandelnde fundiertes Wissen über Möglichkeiten und Grenzen von KI haben. Eine Forschungsgruppe aus der biologischen Kybernetik versuchte, Ähnlichkeiten und Unterschiede zwischen Transformer-Modellen (z.B. ChatGPT-Modell) und dem menschlichen Geist mithilfe von Tests aus der kognitiven Psychologie herauszustellen. Sie fanden, dass GPT3 Entscheidungsaufgaben auf menschlichem Niveau bewältigt, aber anders als Menschen lernt.24 Und trotz Anzeichen von modellbasiertem Verstärkungslernen bewältigt die KI eine Aufgabe zum kausalen Schlussfolgern nicht.24 Neueste Daten der Forschergruppe zeigen, dass KI in einem Angstfragebogen im Allgemeinen höhere Werte als Menschen aufweist und bei Experimenten der Emotionsinduktion bei größerer (induzierter, kognitiver) Angst in Aufgaben diskriminierende (gegenüber nicht weißen, alten und behinderten Personen) Aussagen macht.25

Die Aktualität und gesellschaftliche Reichweite des Themas machen es unabdinglich, Wissensbausteine dazu in die Ausbildung von all jenen Berufsgruppen einzubauen, die mit Betroffenen von psychischen Problemen arbeiten, gerade weil beispielsweise die Chancen wie Grenzen von ChatGPT in psychotherapeutischen wie psychiatrischen Fachkreisen bisher sehr wenig Beachtung finden.26

Literatur:

1 Eichenberg C et al.: KI-basiertes Robotersystem zur Unterstützung der mentalen Gesundheit im Alter: erste AID2BeWell-Projektdaten aus einer Umfrage und Fokusgruppen. Kongress der Deutschen Gesellschaft für Psychiatrie, Psychotherapie und Nervenheilkunde, 23.–26.11.2022, Berlin 2 Eichenberg C et al.: KI-basiertes Robotersystem zur Unterstützung der Gesundheit im Alter: AID2BeWell-Projektdaten aus der ersten Pilotstudie. Deutscher Kongress für Psychosomatische Medizin und Psychotherapie, 03.–05.05.2023, Berlin 3 Eichenberg C et al.: KI-basiertes Robotersystem zur Unterstützung der Gesundheit im Alter: AID2BeWell-Projektdaten aus der zweiten Pilotstudie. Kongress der Deutschen Gesellschaft für Psychiatrie, Psychotherapie und Nervenheilkunde, 29.11.–02.12.2023, Berlin 4 Lee EE et al.: Artificial intelligence for mental health care: clinical applications, barriers, facilitators, and artificial wisdom. Biol Psychiatry Cogn Neurosci Neuroimaging 2021; 6(9): 856-64 5 Reece AG, Danforth CM: Instagram photos reveal predictive markers of depression. EPJ Data Sci 2017; 6(1): 15 6 Banerjee D et al.: A deep transfer learning approach for improved post-traumatic stress disorder diagnosis. IEEE International Conference on Data Mining (ICDM), 18.–21.11.2017, New Orleans, LA. S. 11-20. Verfügbar unter: http://ieeexplore.ieee.org/document/8215473 7 Marmar CR et al.: Speech-based markers for posttraumatic stress disorder in US veterans. Depress Anxiety 2019; 36(7): 607-16 8 Corcoran CM et al.: Prediction of psychosis across protocols and risk cohorts using automated language analysis. World Psychiatry 2018; 17(1): 67-75 9 Abd-Alrazaq AA et al.: An overview of the features of chatbots in mental health: A scoping review. Int J Med Inform 2019; 132: 103978 10 Grové C: Co-developing a mental health and wellbeing chatbot with and for young people. Front Psychiatry 2021; 11: 606041 11 Fitzpatrick KK et al.: Delivering cognitive behavior therapy to young adults with symptoms of depression and anxiety using a fully automated conversational agent (Woebot): a randomized controlled trial. JMIR Ment Health 2017; 4(2): e19 12 Ly KH et al.: A fully automated conversational agent for promoting mental well-being: a pilot RCT using mixed methods. Internet Interv 2017; 10: 39-46 13 Morris R et al.: Towards an artificially empathic conversational agent for mental health applications: system design and user perceptions. J Med Internet Res 2018; 20(6): e10148 14 https://openai.com/blog/chatgpt/ 15 https://www.cais-research.de/news/chatgpt-wie-viele-menschen-kennen-dich-bereits/ 16 Chatterjee J, Dethlefs N: This new conversational AI model can be your friend, philosopher, and guide … and even your worst enemy. Patterns (N Y) 2023; 4(1): 100676 17 Kumar H et al.: Exploring the design of prompts for applying GPT-3 based chatbots: a mental wellbeing case study on mechanical turk. Verfügbar unter: http://arxiv.org/abs/2209.11344 18 Bubeck S et al.: Sparks of artificial general intelligence: early experiments with GPT-4. Verfügbar unter: http://arxiv.org/abs/2303.12712 19 Nori H et al.: Capabilities of GPT-4 on medical challenge problems. Verfügbar unter: http://arxiv.org/abs/2303.13375 20 Deutscher Ethikrat: Mensch und Maschine – Herausforderungen durch Künstliche Intelligenz. Stellungnahme. Verfügbar unter: https://www.ethikrat.org/mitteilungen/mitteilungen/2023/ethikrat-kuenstliche-intelligenz-darf-menschliche-entfaltung-nicht-vermindern/?cookieLevel=not-set 21 Sharma A et al.: Human–AI collaboration enables more empathic conversations in text-based peer-to-peer mental health support. Nat Mach Intell 2023; 5(1): 46-57 22 Schroiff A et al.: Vertrauen in Gesundheitsanwendungen mit künstlicher Intelligenz – Sichtweise der User/Patienten. Deutscher Kongress für Psychosomatische Medizin und Psychotherapie, 16.–18.06.2021, Berlin 23 Imran N et al.: Chat-GPT: opportunities and challenges in child mental healthcare. Pak J Med 2023; 39(4): 1191-3 24 Binz M, Schulz E: Using cognitive psychology to understand GPT-3. Proc Natl Acad Sci USA 2023; 120(6): e2218523120 25 Coda-Forno J et al.: Inducing anxiety in large language models increases exploration and bias. Verfügbar unter: https://arxiv.org/abs/2304.11111 26 Cheng S-W et al.: The now and future of ChatGPT and GPT in psychiatry. Psychiatry Clin Neurosci 2023; 77(11): 592-6

Das könnte Sie auch interessieren:

Therapeutisches Drug-Monitoring (TDM) in der Neuropsychopharmakologie: von der Theorie zur klinischen Routine

Therapeutisches Drug-Monitoring (TDM) verbindet angewandte Pharmakokinetik mit der klinischen Praxis und stellt damit ein wertvolles Instrument der Präzisionsmedizin dar. Absorption, ...

Aktuelle Themen aus der psychiatrischen Forschung und Therapie

Am 6. und 7. November 2025 fand die 27. Jahrestagung der Österreichischen Gesellschaft für Neuropsychopharmakologie und Biologische Psychiatrie (ÖGPB) statt. Im Festsaal der Universität ...

Ketamin-augmentierte Psychotherapie

Das schnell wirksame Antidepressivum (S-)Ketamin wird bei therapieresistenten Patient:innen effektiv eingesetzt. Als zentrale Komponente eines biphasischen Wirkmechanismus wird für ...